Head of AI, Tomasz Smolarczyk o przyszłości AI

Jak AI będzie się rozwijać w najbliższych 12 miesiącach?

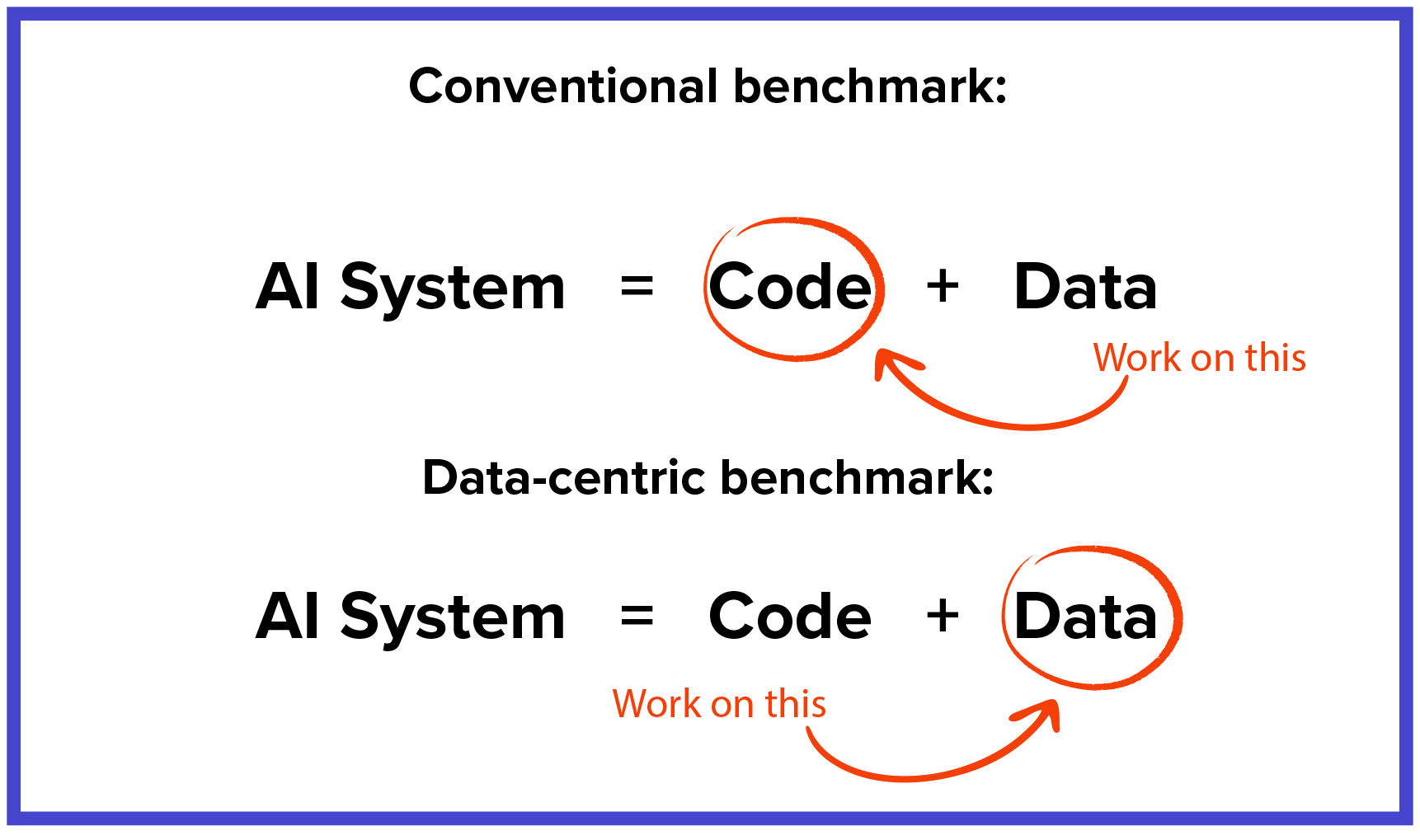

W organizacjach widać zmianę w podejściu do sztucznej inteligencji oraz większy nacisk na poprawne przygotowanie danych. Biznesy coraz lepiej rozumieją, że AI to nie tylko algorytm, ale także dane, które za nim stoją. Już nie myśli się tylko o tym, jak zmienić algorytm i kod, aby dostać lepsze wyniki, ale jak holistycznie podejść do systemu zbierania i przetwarzania wysokiej jakości danych, które posłużą do wyuczenia dobrych modeli. Istnieje też coraz większy nacisk na role związane z data engineering i MLOps, bo organizacje widzą, że znacząco wpływają one na sukces projektów AI-owych.

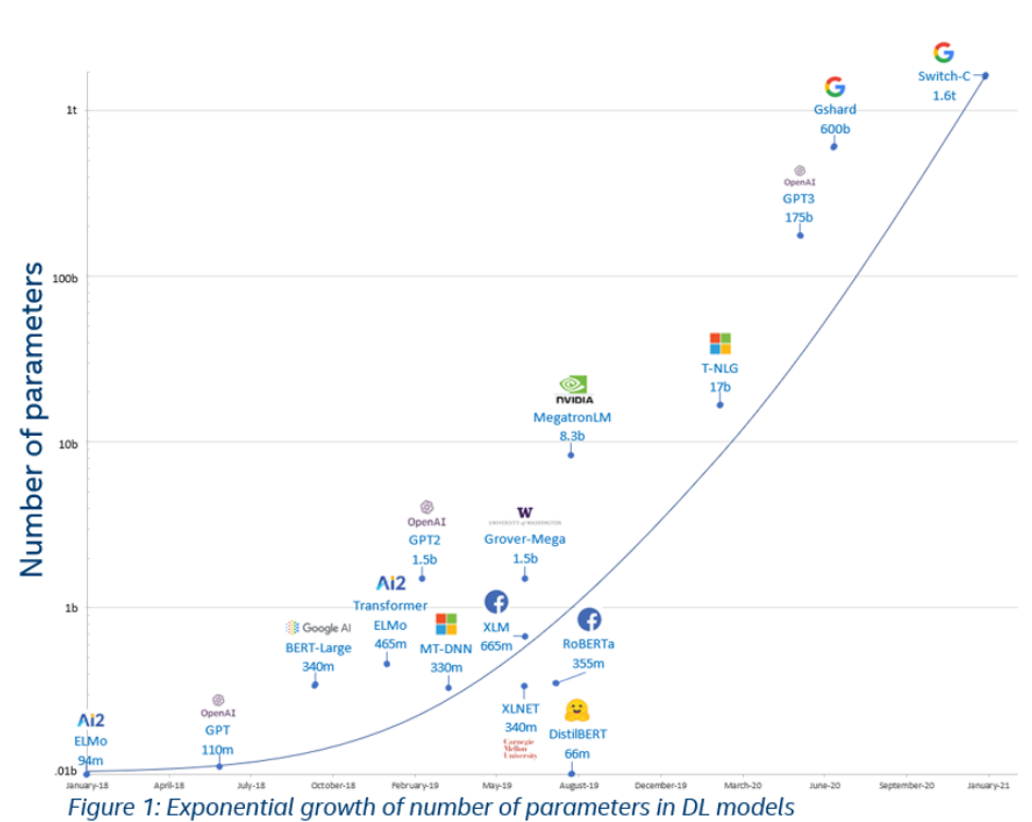

Natomiast jeśli chodzi o świat badawczy, obserwuję trendy związane z projektowaniem coraz bardziej skomplikowanych architektur głębokich sieci neuronowych wykorzystujących ogromne zbiory danych i coraz potężniejsze klastry obliczeniowe. Wystarczy spojrzeć na sytuacje, z którą mamy do czynienia z modelami językowymi – liczba parametrów w tych modelach rośnie w tempie wykładniczym. Google jakiś czas temu zaprezentowało model w architekturze Switch Transformer, który ma 1.6 biliona parametrów, 6-krotnie więcej niż poprzedni wielki model GPT-3 zaprezentowany przez OpenAI.

Drugi z ciekawych trendów to self-supervised learning, które wykorzystuje losowe, nieanotowane przykłady do uczenia modelu. W kwietniu 2021 Facebook opublikował model DINO, który wykorzystując tego typu mechanizmy, osiągnął lepszą jakość predykcji na zadaniach związanych z przetwarzaniem obrazów niż standardowe techniki stosowane do tej pory w oparciu o supervised learning.

Możemy także obserwować coraz szersze zastosowanie głębokich sieci neuronowych do problemów, które nie udało się rozwiązać klasycznymi metodami. Jedno z ciekawszych osiągnięć możemy przypisać firmie Deepmind, która stworzyła algorytm AlphaFold 2 do predykcji tego, jak będą zwijać się białka z dokładnością ponad 90 mierzoną przez Global Distance Test (GDT). Ich projekt wygrał ostatnio konkurs organizowany od lat 90., gdzie badacze z całego świata przewidują, jak będzie wyglądać struktura nowych sekwencji białek. Przyjmuje się, że wynik powyżej 90 GDT jest porównywalny z tymi jakie można osiągnąć poprzez eksperymentalne wyznaczanie struktury.

Jak obecnie rozwija się tzw. explainable AI?

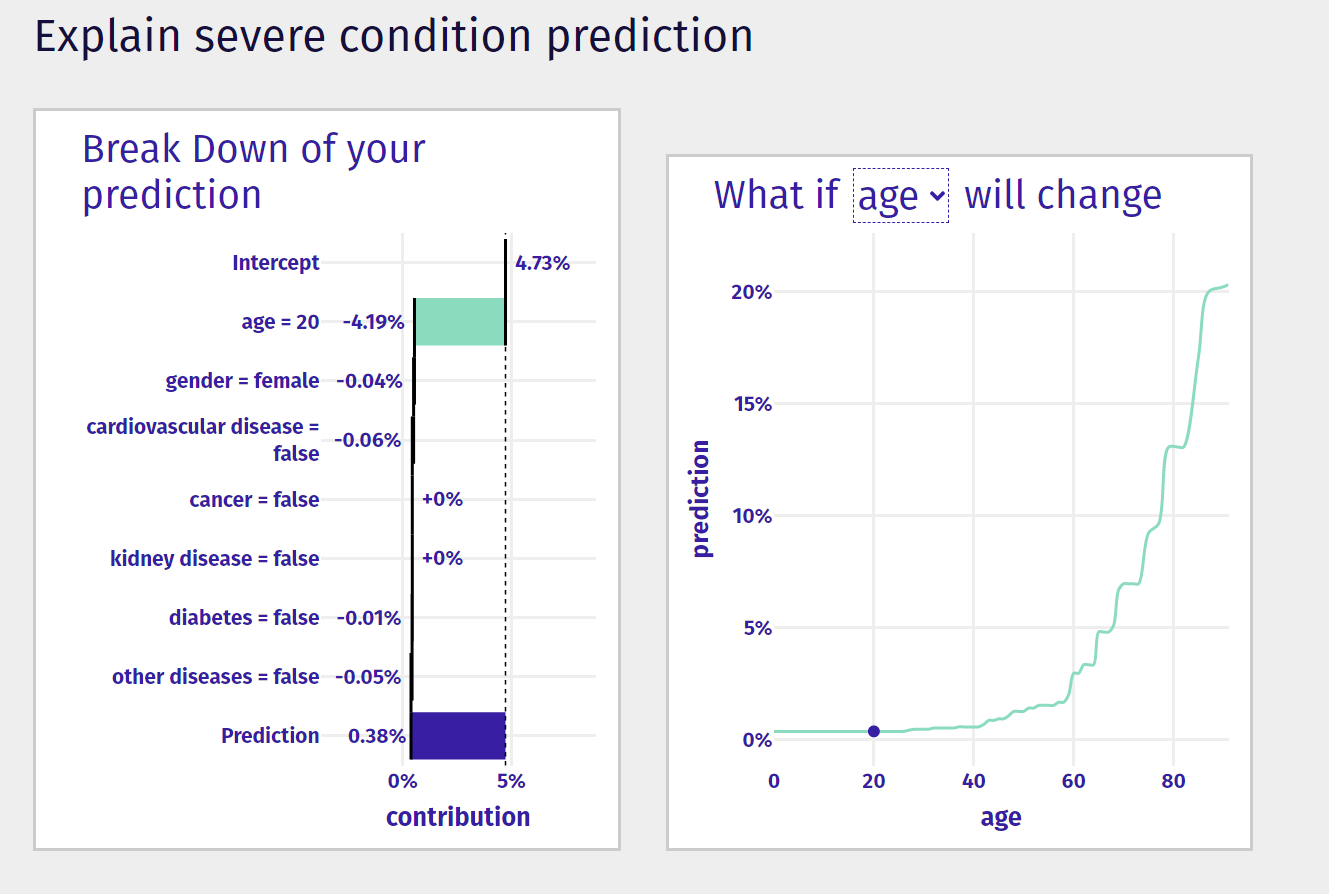

Świetny przykład przygotowała grupa MI2 DataLab i grupa MOCOS. Zbudowali model w oparciu o dane pacjentów, którzy przeszli Covid-19, gdzie można sprawdzić, jakie są szanse, że przejdziemy tę chorobę w poważny sposób albo że dany pacjent umrze. W formularzu można wpisać wiek i choroby towarzyszące. Dostajemy dość dokładną wartość predykcji zaprezentowaną w atrakcyjny i łatwy do zrozumienia sposób, gdzie widzimy, co za takim modelem się kryje.

Techniki tego typu stają coraz istotniejsze, ponieważ pozwalają wykryć tzw. bias w danych. Powstają coraz to nowsze techniki do diagnozowania i wizualizacji tego typu problemów – obecnie niektóre modele mogą faworyzować lub uprzedzać się do pewnych grup. Dzięki tym technikom będziemy mogli tworzyć modele, które są bardziej uniwersalne i wyjaśnialne.

Jednym z przykładów takiego bias może być tłumaczenie Google, w którym zdania “On/ona jest pielęgniarzem. On/ona jest lekarzem” w języku tureckim, były tłumaczone na angielski jako “Ona jest pielęgniarką. On jest lekarzem”, a zdania “On/ona jest leniwy/a. On/ona jest pracowity/a” na “Ona jest leniwa. On jest pracowity.” Akurat ten błąd w tłumaczeniu został naprawiony i w przypadku bezosobowego zaimka “o” w języku tureckim dokonując automatycznego tłumaczenia, można wybrać właściwy zaimek.

Pandemia jest też takim ciekawym okresem dla AI – pojawiło się wiele narzędzi, które próbują tłumaczyć modele rozwoju pandemii i jak można wykorzystać te dane do długofalowych predykcji.

W Spyrosoft też realizujemy projekt z funduszy Narodowego Centrum Badań i Rozwoju, w którym – wspólnie z firmą U+GEO, spin-offem Uniwersytetu Przyrodniczego – symulujemy rozprzestrzenianie się chorób zakaźnych, wykorzystując do tego dane na temat mobilności. Można w takich symulacjach zweryfikować, jak np. zamknięcie restauracji i/albo centrów handlowych może wpłynąć na rozwój chorób zakaźnych, w tym Covid-19. Mamy tutaj do czynienia z możliwością testowania różnych scenariuszy, które mogą być wykorzystane przez osoby decyzyjne do wyboru strategicznych działań, które dadzą najlepsze efekty przy najmniejszych negatywnych skutkach dla gospodarki.

Jakie są potencjalne blokery dla rozwoju AI? Czy takim blokerem może być kończąca się moc obliczeniowa?

Zdecydowanie, jak już wspominałem, powstają modele do analizy tekstu, które są coraz większe, więc te wymagania techniczne też cały czas rosną i wraz ze wzrostem zbieranych danych one będą coraz większe. Natomiast hardware również nieustannie się rozwija, np. komórki teraz dostają specjalnie dedykowane jednostki, które są odpowiedzialne za sieci neuronowe i wykonywanie predykcji w różnego rodzaju zadaniach. Dla przykładu, procesor Apple A14 wykorzystywany w iPhone’ach 12 ma specjalne dedykowany hardware do sieci neuronowych nazywany 16-rdzeniowym Neural Engine, który potrafi wykonywać 11 bilionów operacji na sekundę. To jest liczbą, którą ciężko jest sobie nawet wyobrazić! Te technologie przenoszą się cały czas na coraz to mniejsze urządzenia, więc to się dzieje nie tylko w wielkich serwerowniach.

Jak AI może pomóc w rozwiązaniu zagadnień związanych z ekologią i ograniczaniem zużycia zasobów?

AI jak najbardziej może i już podejmuje tematy związane z ekologią i naszą planetą. Takim prostym rozwiązaniem jest np. algorytm, który pozwala opracować video, jak dana osoba wyglądałaby w ubraniach, które chce zamówić ze sklepu internetowego. Widziałem ostatnio takie rozwiązanie i o ile we wcześniejszych tego typu produktach, rozdzielczość i jakość nagrania nie były wysokie, to to narzędzie na pewno mogłoby znaleźć zastosowania komercyjne w branży ecommerce. To pozwoliłoby obniżyć ilość zwrotów produktów zamówionych online, co na pewno byłoby bardziej ekologiczne i ograniczałoby zużycie zasobów.

Organizacja Narodów Zjednoczonych zdefiniowała 17 takich globalnych wyzwań i jednym z nich jest właśnie walką ze zmianami klimatu. W ramach ich programu pojawiło się już kilka projektów AI, które skupiają się właśnie na tym wyzwaniu. Jedynym z przykładów jest narzędzie oparte na sztucznej inteligencji, za pomocą którego można obserwować różne gatunki wielorybów. Powstały modele Machine Learning, które badają ich populację, automatycznie wykrywając, w którym miejscu się znajdują się te zwierzęta.

Kolejnym takim wyraźnym trendem jest używanie danych do potwierdzania hipotez oraz do przełamywania takiej perspektywy, że świat idzie w jakimś bardzo złym kierunku. Takie książki jak ‘Nowe Oświecenie’ Stevena Pinkera czy ‘Factfulness’ Hansa Roslinga pokazują w oparciu o, że na świecie generalnie żyje się coraz lepiej i dłużej.

Czy nadal jest duże zainteresowanie i chęć rozwijania tzw. general AI?

Nadal są grupy badawcze, które się tym zajmują, ale też nie sądzę, by w ciągu najbliższych kilku lat dojście do general AI było w ogóle możliwe. Sytuacja związana z Covid-19 raczej tego nie zmienia. Nie wydarzyło się jeszcze nic takiego, co by sprawiło, że ten temat zostałby skreślony.

Myślisz, że możliwe jest w pewnym momencie dojście do takiego general AI?

Tak jak mówiłem wcześniej, nie mamy na razie dowodów ani za potwierdzeniem, ani za zaprzeczeniem możliwości stworzenia general AI. Możemy przypuszczać tylko, że nie wydarzy się to szybko [śmiech].

Choć niektóre media określiły model GPT-3 opracowany przez OpenAI mianem przyszłego SkyNetu (nawiązanie do serii filmów Terminator), to sieć ta wciąż nie wykazuje podstawowego zrozumienia językowego. Owszem osiągane przez nią rezultaty są imponujące, ale nie zmienia to faktu, że jeszcze daleka droga przed nami. Na przykład, człowiek jest w stanie wydedukować, że w zdaniu: „Stolik w rogu chce zamówić kolejną szklankę wody”, nie chodzi o faktyczny stolik (mebel) tylko o osobę siedzącą przy stoliku w rogu. Obecne modele nie potrafią jeszcze w ten sposób rozumować.

O autorze